Le rapport PE 776.426, remis en juillet 2025 au Comité JURI du Parlement européen par le Professeur Andrea Bertolini, acte une rupture majeure dans l’approche du droit européen de la responsabilité civile appliqué aux systèmes d’intelligence artificielle (IA). Initialement pensée autour de la responsabilité postérieure à la survenance d’un dommage – fondée sur une logique de réparation et de dissuasion –, la régulation de l’IA s’oriente désormais vers une gouvernance ex ante, incarnée par le Règlement (UE) 2024/1689 sur l’intelligence artificielle (AI Act), au détriment de l’ambition initiale d’unification des règles de responsabilité.

Cette inversion normative — du post vers l’ex ante, du curatif vers le préventif — se traduit par l’érosion progressive du projet de Directive sur la responsabilité civile en matière d’IA (AILD), dont la Commission a annoncé le retrait envisagé dans son programme de travail 2025. Ce déplacement de centre de gravité réglementaire est dénoncé par l’auteur du rapport comme un abandon prématuré de l’objectif d’harmonisation juridique au profit d’une fragmentation accrue des régimes nationaux.

« Soft-law elements originally conceived as auxiliary have become the core of EU hard-law intervention, while the envisioned liability regime has been indefinitely postponed » (p. 22).

Le régime issu de la Directive 85/374/CEE sur la responsabilité du fait des produits défectueux (PLD), bien que récemment modernisé par la Directive (UE) 2024/2853 (PLDr), demeure fondamentalement inadapté à la technicité et à l’opacité des systèmes d’IA. S’il intègre désormais les logiciels dans la définition des produits, le PLDr conserve une approche fondée sur la « défectuosité » du produit, inapte à appréhender les effets émergents ou les comportements non anticipés d’un système auto-apprenant.

Le rapport relève notamment :

« The PLDr leaves intact the substantive limitations that rendered the PLD largely ineffective in the first place » (p. 11).

La proposition de directive sur la responsabilité de l’IA (AILD, COM(2022) 496 final) devait pallier ces insuffisances en instaurant des outils procéduraux harmonisés (obligations de divulgation, présomptions de faute et de lien de causalité). Mais elle repose sur une logique hybride et instable : d’une part, elle conserve la primauté des régimes nationaux fondés sur la faute ; d’autre part, elle introduit des éléments d’objectivation sans construire un véritable régime autonome.

Le rapport critique la faiblesse de l’efficacité normative de l’AILD, qui risque d’engendrer davantage d’incertitude que de prévisibilité :

Il anticipe la non-application de fait de la directive et le retour de juridictions nationales vers des régimes plus simples, notamment les rares régimes de responsabilité objective existants.

Le cœur de la recommandation du rapport repose sur l’instauration d’un régime de responsabilité strictement objective, ciblé sur les systèmes d’IA à haut risque (high-risk AI systems, h-AIS). Ce régime, inspiré de la proposition parlementaire RLAI (2020/2014(INL)) et du projet de 2020 sur la « responsabilité du fait de l’IA », repose sur les principes suivants :

L’idée centrale est d’identifier un opérateur unique (single operator) – responsable de l’exploitation économique du système et détenteur du contrôle fonctionnel sur celui-ci – comme débiteur exclusif de la réparation, indépendamment de toute faute. Cette approche se substitue à la recherche causale complexe ou à l’imputation fondée sur la faute.

« Liability should be imposed on the single entity that controls the AI system and economically benefits from its deployment » (p. 12).

Pour assurer la cohérence du droit européen, le rapport propose de calquer la notion d’“opérateur” sur les définitions du fournisseur et du déployeur issues de l’article 3 du Règlement AI Act, favorisant ainsi une convergence réglementaire interrégime.

La responsabilité stricte permet :

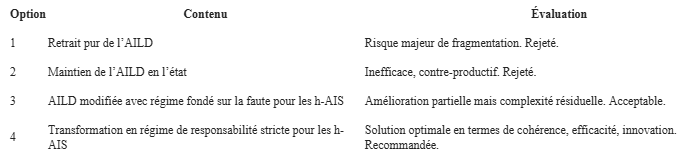

Le rapport identifie quatre scénarios réglementaires :

L’absence d’un régime harmonisé, objectif et autonome de responsabilité pour les systèmes d’intelligence artificielle constitue, à l’échelle de l’Union européenne, une lacune stratégique majeure. L’alternative est clairement posée : soit l’Union assume un leadership normatif en matière de responsabilité des IA à haut risque, au service d’un marché unique fonctionnel et compétitif, soit elle s’expose à une fragmentation croissante du droit, préjudiciable à la fois à la protection des citoyens et à l’innovation.

Le rapport PE 776.426 se positionne sans ambiguïté en faveur d’un modèle européen de responsabilité technologique fondé sur la stricte objectivation du risque, la centralisation de la responsabilité et l’efficacité indemnitaire. Il appartient désormais au législateur européen de trancher entre prudence politique et audace juridique.